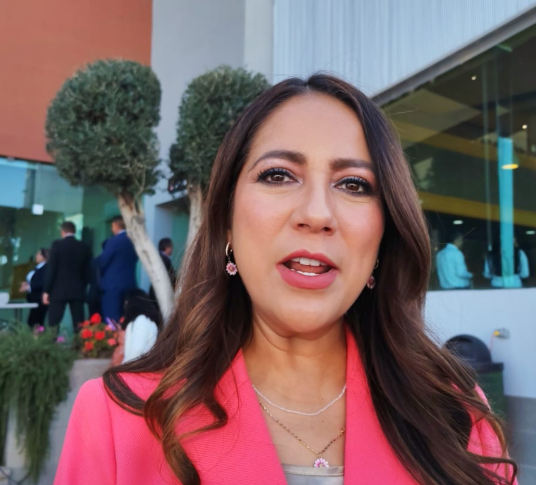

La influencer Alana Flores denuncia haber sido víctima de “deepfakes”; tomará acciones legales

CIUDAD DE MÉXICO (apro) .- A través de sus redes sociales, la streamer e influencer Alana Flores, expuso que fue víctima de “deepfake” tras la difusión de una supuesta imagen íntima suya, creada con Inteligencia Artificial (IA), por lo que tomará acciones legales contra el responsable.

Los “deepfakes” son archivos de video, imagen o voz alterados con IA, de modo que parecen auténticos y reales. A menudo se utilizan para acosar y extorsionar a las víctimas, explica la Oficina Federal de Investigación de Estados Unidos (FBI).

En los últimos días ha circulado una imagen de Flores durante una supuesta situación íntima, misma que la influencer desmintió:

“Hay una imagen falsa de mí que está siendo difundida en redes sociales que ha sido alterada, sea por Inteligencia Artificial o sea por una persona. El caso es que es una imagen que no soy yo, es una imagen en la que utilizaron mi cara y no es real, nunca me la tomaron y nunca pasó”, sostuvo en un video publicado en X.

“No tengo fotos ni videos haciendo actos sexuales, no tengo fotos desnuda, ni tampoco tengo o he tenido OnlyFans o algo por el estilo”, agregó.

La también presidenta del Raniza FC –equipo de la Kings League Américas–, compartió que la situación le afectó física y emocionalmente, por lo que requirió atención médica y apoyo psiquiátrico:

“Ayer tuve una consulta en el hospital porque esto es algo que me ha empezado a repercutir en la salud hasta de manera física (...) (tengo) ya un tiempo con la psiquiatra y, aun así, a veces se siente imposible avanzar estando rodeada de tanta contaminación”.

Asimismo, expuso que ya había sido víctima de “deepfake” muchas veces, pero que “nunca había llegado a tal gravedad”:

“Me hace sentir mucho coraje e impotencia estar en esta situación porque ya no sé qué hacer”, dijo en el video.

La influencer sostuvo con firmeza que tiene proyectos en los cuáles enfocarse, que cuenta con apoyo y que no se dejará derrumbar.

Además, anunció que tomará acciones legales contra el responsable, a quien supuestamente ya tiene identificado: “No es real. Y si voy a buscar demandar”, escribió en X.

“Para los que dicen que, si voy a demandar a una IA, tengo la persona que lo inició, y aunque haya borrado su cuenta @chainsant1, sé que fue él”, agregó en la publicación.

¿Qué son los “deepfakes” y sus riesgos?

Los “deepfakes” son imágenes, vídeos o audio editados o generados utilizando inteligencia artificial o software de edición audiovisual, y usan la apariencia de una persona para aparentar que realizó alguna actividad o que dijo algo utilizando su voz.

En internet se popularizado la edición de imágenes y audios para generar contenido erótico o pornográfico.

Al ser casi indistinguibles de la realidad, los “deepfakes” representan un problema para la población y, en el caso de Alana Flores, es un recordatorio sobre los riesgos del uso indebido de la IA y su impacto físico y emocional.

De acuerdo con el Instituto LISA y la Oficina de Seguridad del Internauta (OSI), además de pornografía, también se usa para:

- Propagar noticias falsas.

- Generar desinformación.

- Desacreditar a alguien.

- Fraudes y estafas financieras.

- Cometer delitos informáticos relacionados con el honor o la imagen.

- Influir en las votaciones, toma de decisiones o pensamiento grupal.

- Venganzas y extorsión.

- Desestabilizar las relaciones internacionales.

- Ciberacoso o acoso escolar.

- Viralización de contenido falso "que puede causar estragos en la reputación de una persona”.

- Pruebas “verídicas” en los tribunales.

¿Cómo detectar "deep fakes"?

El Instituto LISA recomienda poner atención a los siguientes elementos para detectar “deepfakes”:

- Fallas: Identificar diferencias en las expresiones faciales, la iluminación, bordes borrosos, movimientos entrecortados, etcétera.

- Parpadeo: En un “deepfake”, la persona parpadea menos veces de las que lo haría una persona en un video real.

- Cuello y la cara: Si las características del cuerpo no coinciden con las de la persona real, puede tratarse de un archivo falso.

- Corta duración: Todos los “deepfakes” tienen una duración muy corta, ya que el proceso de IA lleva mucho trabajo.

- Origen de la grabación: Indagar sobre quién compartió el archivo, en qué redes sociales, contexto en que se publicó y sus detalles originales, puede ayudar a detectarlos.

- Sonido: Es frecuente en estos videos no se ajusta correctamente el sonido a la imagen, por lo que no hay sincronización entre el movimiento de los labios y el sonido.

- Detalles: Se recomienda reproducir el video a velocidad reducida para ver modificaciones repentinas o cambios en el fondo.

Con información de: Proceso.

Tips al momento

Movimiento desde temprano para el Cuarto Informe de Maru Campos.

Ciudadanos y funcionarios comienzan a llegar

Del crucero al bote de basura

En el bote de basura fue donde termino un ejemplar del periódico con la imagen de Maru Campos, luego de que presunto personal del Gobierno del Estado los entregara en un crucero de la ciudad.

Aunque en redes se observó la distribución del material, el destino final de algunos impresos llamó la atención.

Policía en Centinela genera expectación; detalles aún sin confirmar

Se registra presencia de policías estatales y municipales frente al edificio Centinela. Hasta el momento, no se ha dado información oficial sobre la causa del movimiento. Empleados de la obra indicaron desconocer los motivos. Extraoficialmente, se mencionó que podría tratarse de una reunión privada, aunque no se ha precisado de quién.

Así amanece la frontera: tráfico intenso

Desde temprana hora se registra fuerte carga vehicular en toda la ciudad, reflejo del creciente número de automóviles que circulan diariamente en la frontera.

La movilidad se vuelve cada vez más complicada, especialmente en horas pico, por lo que se recomienda a los conductores salir con anticipación, manejar con precaución y considerar tiempos prolongados de traslado.

Falla en izamiento de bandera retrasa acto cívico

Esta mañana, durante el acto cívico de izamiento de bandera encabezado por autoridades municipales, se registró un inconveniente técnico cuando el lábaro patrio se enredó mientras era elevado.

Debido a esta situación, el personal encargado tuvo que bajar nuevamente la bandera para desenredarla y reiniciar correctamente el protocolo de ascenso.

“Listo, montado y armado”: Cruz Pérez Cuéllar se dice preparado para la gubernatura 2027

El presidente municipal de Ciudad Juárez, Cruz Pérez Cuéllar, aseguró estar “listo, montado y armado” para contender por la gubernatura de Chihuahua en el proceso electoral de 2027.

Al ser cuestionado sobre sus aspiraciones políticas, el alcalde no descartó su interés en participar en la contienda estatal, dejando en claro que se encuentra preparado para asumir el reto en caso de que las condiciones se den.

Sus declaraciones se dan en medio del escenario político rumbo a la sucesión estatal, donde diversos perfiles comienzan a posicionarse de cara al próximo proceso electoral.

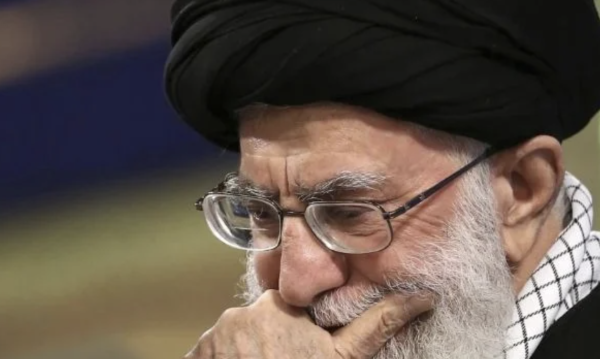

La muerte de "El Mencho" le rebota a AMLO

Importantísimo el dato que confirma la propia secretaría de defensa Nacional, de que hubo un operativo conjunto con fuerzas especiales de los Estados Unidos y esto trae a colación otro dato sumamente clave: hasta dónde la secuencia del abatimiento del Mencho recaerá en el expresidente Andrés Manuel López Obrador en cuyo gobierno creció y floreció el cartel de Jalisco Nueva generación como nunca, superando sus acciones delictivas al cartel de Sinaloa al que extrañamente con la captura de El Mayo, se desató una guerra intestina que está acabando con ambas fuerzas en el Estado de Sinaloa.

¿Seguirán ahora las consecuencias para un presidente que dejó libre el territorio mexicano y que fortaleció el cartel Jalisco Nueva Generación?, es la pregunta que debe ser contestada y por otra parte también frente a toda la consecuencia que ha logrado este impacto mundial con la nota del presunto abatimiento de Nemesio Oceguera, El Mencho.

Es importante que las autoridades muestren el cuerpo de El Mencho, pues ya hay especulaciones de que no fue abatido y que las reacciones de su ejército de sicarios lo hacen porque no creen que su jefe haya sido acribillado por las fuerzas federales en coordinación ahora, lo sabemos, con fuerzas especiales de los Estados Unidos, a quién López Obrador nunca dejó entrar y que hasta expulsó a los agentes de la DEA, creando un narco Estado.

Pero lo más raro, es que la Presidenta Claudia Sheinbaum no se haya colgado una medalla valiosísima con el abatimiento de El Mencho, cuando es el dato histórico que le vale un enorme reconocimiento incluso mundial en el combate al crimen organizado.

Omitió dar una declaración y lo dejó en manos del gabinete de seguridad.

¿Por qué dejó ir Sheinbaum esa oportunidad...?

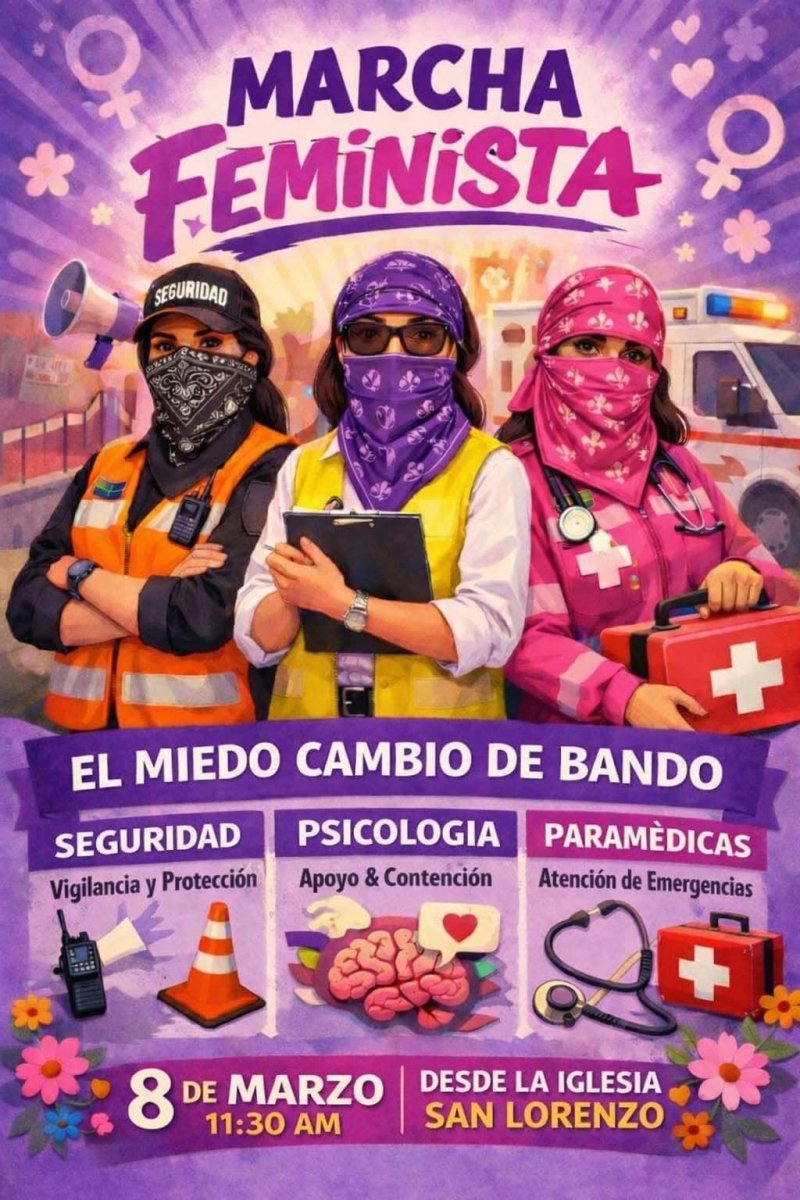

Colectivos se preparan para el 8M en Juárez

A días del Día Internacional de la Mujer, comienzan a circular en redes sociales convocatorias de colectivos que anuncian su participación este 8 de marzo en Ciudad Juárez bajo consignas como “¡Por nosotras y para nosotras!”.

Entre los elementos que destacan está la conformación de contingentes exclusivos para mujeres, la creación de espacios de acuerpamiento y la presencia cercana de apoyo médico y psicológico.

Estudiantes aprovechan para tomarse la selfie con Bonilla en su recorrido por Ciudad Juárez.

Bonilla visitó Ciudad Juárez y convivió con estudiantes del Colegio de Bachilleres, con quienes se tomó selfies y dialogó sobre educación, empleo y movilidad. “Me gusta venir a platicar con los jóvenes, son el futuro de nuestra ciudad y es importante escuchar sus ideas y preocupaciones”, expresó. ¿Comienza así a preparar el camino rumbo a 2027?

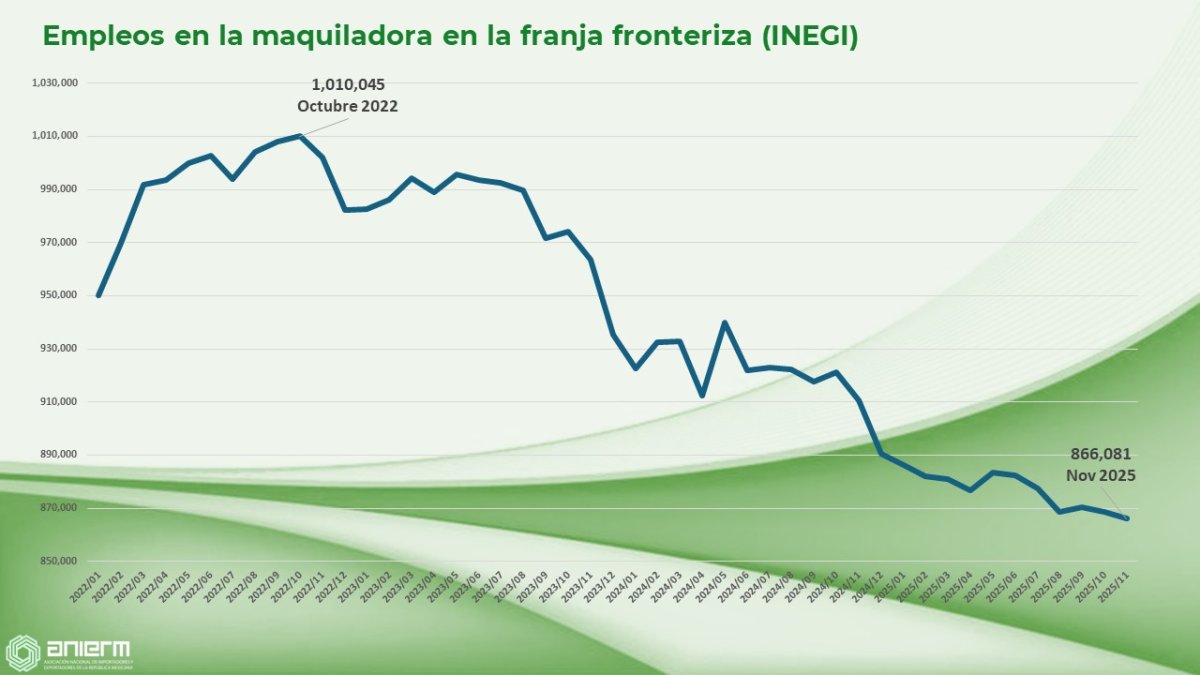

Maquiladora fronteriza pierde más de 140 mil empleos en tres años, según INEGI

De acuerdo con datos del INEGI, el empleo en la maquiladora de la franja fronteriza alcanzó su punto más alto en octubre de 2022 con 1,010,045 trabajadores; para noviembre de 2025 la cifra cayó a 866,081, lo que representa una pérdida de más de 140 mil empleos en poco más de tres años.

Circulan memes tras caída de cristales en Centinela

Tras la caída de vidrios en la Plataforma Centinela, comenzaron a circular memes en redes sociales haciendo burla del edificio, aún en construcción.

Usuarios ironizan que al primer fenómeno climático el inmueble presentó fallas, lo que ha desatado críticas y comentarios sobre la millonaria obra estatal.

¿“Therians” aparecen en libros de texto?

En redes sociales circula información que asegura que los “therians” aparecen en libros de texto de la SEP.

De acuerdo con las imágenes compartidas, el contenido corresponde a una actividad del libro de proyectos comunitarios de tercer grado, donde se utilizan ilustraciones de animales para explicar dinámicas de movimiento y trabajo en equipo.

El tema ha cobrado relevancia tras la salida de Marx Arriaga de la Dirección General de Materiales Educativos de la SEP, área responsable de la elaboración de los nuevos libros de texto. Su relevo se dio en medio de desacuerdos internos sobre posibles ajustes a los contenidos educativos, lo que volvió a poner en el centro del debate público el tema de los materiales escolares.

Dudan de encuesta que coloca a Cruz Pérez Cuéllar al frente en Morena

Cruz Pérez Cuéllar encabeza las preferencias internas de Morena rumbo a la gubernatura de Chihuahua en 2027, de acuerdo con una supuesta encuesta de MetaMetrics, donde supera por casi tres puntos a su más cercana competidora. La medición lo coloca como el perfil mejor posicionado dentro del partido, en un escenario donde aún hay un porcentaje de indecisos.

La información ha sido difundida a través de una página de Facebook y en los comentarios de la misma publicación, varios usuarios han expresado dudas sobre la autenticidad y los resultados del sondeo.

CANACO felicita a Carlos Noé Hernández por su nombramiento al frente de CANACINTRA

A través de sus redes oficiales, la Cámara Nacional de Comercio (CANACO) anunció la felicitación al Lic. Carlos Noé Hernández por su nombramiento como nuevo presidente de CANACINTRA.

En la publicación, el organismo empresarial le deseó una gestión llena de logros, trabajo en equipo y resultados positivos para el sector industrial y la comunidad.

Cruz Pérez Cuéllar lidera ranking nacional de aprobación

El alcalde de Ciudad Juárez, Cruz Pérez Cuéllar, aparece en el primer lugar del ranking de aprobación de alcaldes correspondiente a enero de 2026, elaborado por Demoscopía Digital y publicado por La Jornada Estado de México.

Con 70.1 por ciento de aprobación, el edil juarense encabeza la medición en la primera circunscripción.

Ciudad Juárez se coloca así como el municipio mejor evaluado dentro de este ejercicio.

Loya comienza a marcar territorio en Juárez

Las bardas en Juárez empiezan a mandar señales. Esta vez con la imagen y el nombre de Gil Loya, bajo el lema “Construimos Juntos”, una frase que suena más a posicionamiento que a simple cortesía gráfica.

En un momento donde varios perfiles estatales han intensificado presencia en territorio fronterizo, estas pintas no pasan desapercibidas. No es casualidad que la promoción se dé fuera de tiempos electorales formales: el termómetro político comienza a moverse antes de lo que muchos admiten… y las bardas suelen ser el primer aviso.

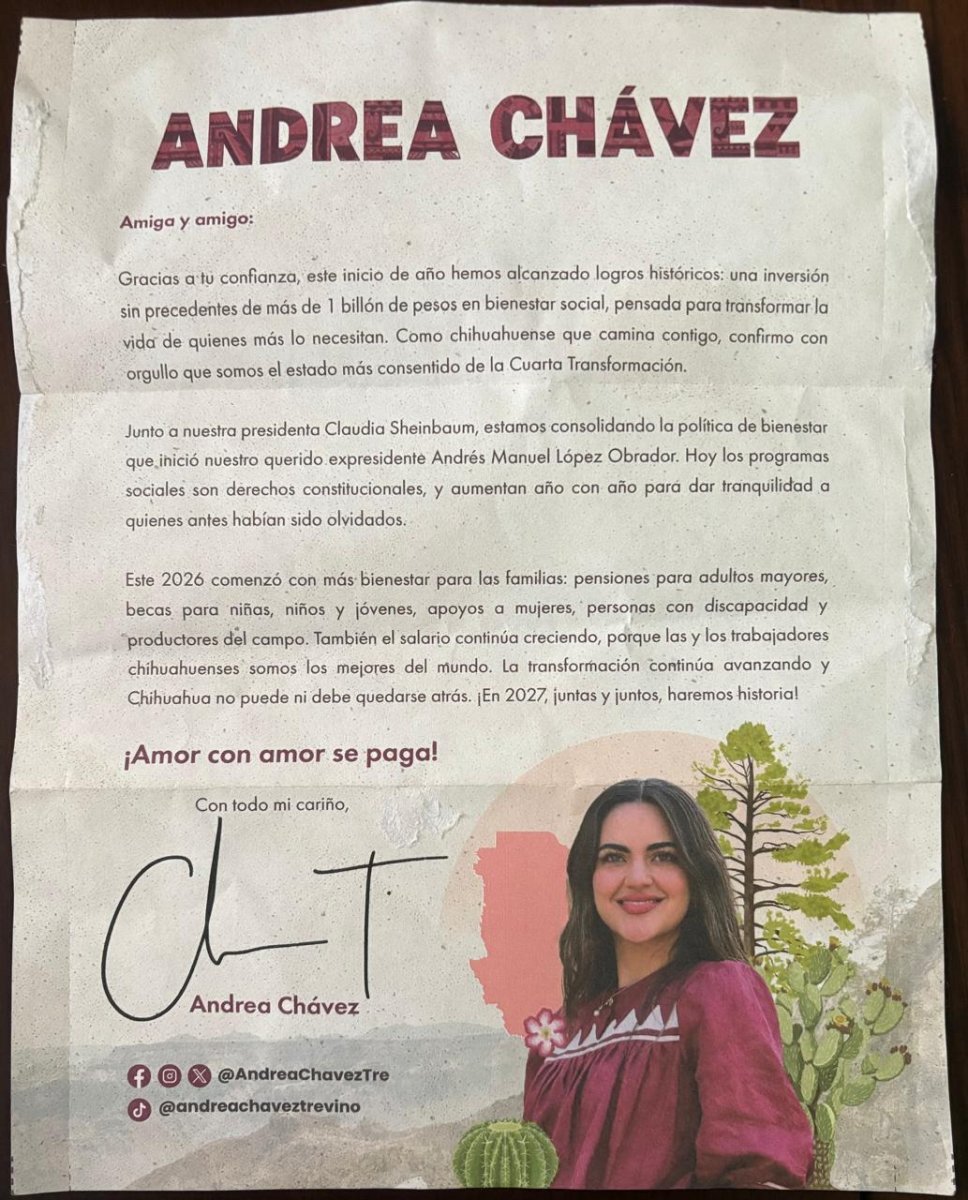

Circula en redes polémica contra Andrea Chávez por presunta propaganda y vestimenta indígena

Circula en redes una publicación contra Andrea Chávez por presunta propaganda dejada en domicilios. En el mensaje la acusan de “dejar basura” en una vivienda y también cuestionan que utilice vestimenta indígena, señalando una supuesta incongruencia con posturas sobre apropiación cultural. La publicación se viralizó rápidamente y generó reacciones divididas entre usuarios.

Inaugura Andrea Chávez el "colgadero" de lonas personalizadas en las casas

Previo al proceso electoral, a pesar de que éste inicia en octubre del presente año, ya no sólo saturan de pintas y entrega de volantes en las calles, ahora inicia la colgadera de lonas personalizadas de personajes que han manifestado su intención de competir en el 2027.

Tal es el caso de la Senadora Andrea Chávez, de quien ya comenzaron a colgarse una serie de lonas en algunas viviendas de la capital del Estado con su nombre y su imagen, no hace referencia a su cargo actual.

Como en cada lapso previo al proceso electoral, ha sido muy común ver este tipo de lonas de posibles aspirantes colgadas en casas.

Los mensajes promocionales de Bustillos...

Aunque el presidente de la Unión Ganadera Regional de Chihuahua, Álvaro Bustillos, ha manifestado públicamente no estar buscando contender en el proceso electoral de 2027, trascendieron mensajes de texto promoviendo sus labores al frente de la UGRCh.

Hoy comenzó a circular entre ciudadanos un mensaje vía SMS en el que se destacan las gestiones y trabajos realizados en Washington en materia de blindaje sanitario, tema clave para el sector ganadero de la entidad. En el mensaje se subrayan acciones encaminadas a fortalecer las medidas sanitarias y proteger la exportación de ganado chihuahuense, uno de los principales motores económicos del estado.

La difusión de este tipo de contenidos ha generado comentarios sobre su promoción personal que empata con las acciones de diversas figuras rumbo a la gubernatura de 2027.

Del "mugrero" de la Torre Centinela, a "Don Ramón" del Chavo del 8

Tuvo eco la expresión del alcalde de Juárez, Cruz Pérez Cuéllar en contra del PAN, en esa campaña abierta sobre este partido a raíz de la guerra hacia la presidenta Daniela Álvarez, en la cual, además de calificar a la Torre Centinela como un "mugrero", ahora el edil fronterizo evoca a "Don Ramón", el icónico personaje del Chavo del 8 para adecuarlo a las conductas políticas del albiazul en el sentido de que este personaje nunca tenía para pagar la renta de la vecindad, en un símil a que el PAN no paga el predial.

Pacto de Andy López y Adán Augusto contra Sheinbaum en candidaturas al 2027

La reciente columna del periodista Mario Maldonado, ha generado la atención este martes en Chihuahua, al mencionarse un presunto pacto entre Andy López Beltrán y Adán Augusto para operar en contra de Claudia Sheinbaum en las candidaturas a las gubernaturas en 2027, incluyendo a Chihuahua con Andrea Chávez.

En dicha editorial titulada Historias de NegoCEOs, este pacto de Andy y Adán, es imponerse contra a presidenta de Morena, Luisa María Alcalde, y al del equipo de Sheinbaum.

La supuesta imposición de Adán Augusto hacia Andrea Chávez como candidata a la gubernatura de Chihuahua, no es un hecho aislado, porque también pretender imponer al actual director de la Agencia Nacional de Aduanas de México, Rafael Marín Mollinedo, a la gubernatura de Quintana Roo.

Este manotazo de López Obrador, busca evitar que otros grupos incidan en la designación de los 17 candidatos a gobiernos estatales y al Congreso.

"Andy" se mantendrá en la Secretaría de Organización del partido y hará suyas todas las victorias que obtenga Morena.

En Chihuahua la idea sería Andrea Chávez para competir por Chihuahua, en detrimento de un candidato que en Palacio Nacional ya tenían muy trabajado: el alcalde de Ciudad Juárez, Cruz Pérez Cuéllar.

Volantes de Andrea, al estilo de AMLO y promoción del Bienestar

En la ciudad de Chihuahua circulan volantes de Andrea Chávez, con su imagen, vistiendo una blusa indígena, con un nopal y el mapa del Estado de fondo, e incluye la frase “en 2027, juntas y juntos haremos historia”, que recuerda la coalición electoral de MORENA, PT y el extinto PES oportunista, que postularon a AMLO en 2018.

En los volantes personalizados de Andrea Chávez, se destaca la inversión que se ha hecho en los programas de la Secretaría del Bienestar, mismo que tiene bajo su mando la secretaria Ariadna Montiel y que opera en Chihuahua, Mayra Chávez.

Logra Somos MX requisitos para su registro como partido político

A través de redes sociales, Somos MX presumió que ya cuenta con los requisitos necesarios para su registro como partido político a nivel nacional. En el post de X, compartieron que este fin de semana alcanzaron las 231 asambleas y 256 mil afiliados.

"Cubiertos los requisitos, no habrá manera de que el INE pueda negar el registro ganado en las calles con voluntad y la participación de cientos de miles ciudadanos y ciudadanas mexicanas", compartieron el redes.

Cabe mencionar que esta organización derechista, ya tiene a delegadas y delegados para llevar a cabo la Asamblea Nacional Constitutiva que se espera, sea el próximo 21 de febrero en la Ciudad de México.

Respalda Corral candidatura de Andrea Chávez

El senador Javier Corral, respaldó a la senadora Andrea Chávez para la contienda de la gubernatura de Chihuahua, esto tras las declaraciones del congresista Adán Augusto quien aseguró que la morenista gobernará en 2027.

“Es una precandidata que está muy bien posicionada, tiene una presencia muy activa en el estado y es probable que pueda ser candidata a la gubernatura por Morena”, dijo.

Esto contrasta con los comentarios del alcalde de Ciudad Juárez, Cruz Pérez Cuéllar, quien, tras escuchar la declaración del ex coordinador de Morena en el senado, y a pesar de pertenecer al mismo partido, dijo que el Senador no impondrá al candidato, y los Chihuahuenses son quienes lo decidirán.

El descaro de Brugada y la percepción de inseguridad

Increíble que la Jefa de Gobierno de la Ciudad de México, Clara Brugada, haya respondido a medios de comunicación que deberían de “bajarle” a la nota roja para disminuir la percepción de inseguridad en algunas alcaldías, el comentario catalogado por muchos como un descaro, deja ver de nueva cuenta la respuesta de la 4T hacía la violencia que enfrenta el país.

Y es que el día de ayer, la jefa de gobierno expuso que la difusión por medio sobre todo de noticieros de televisión sobre hechos violentos es la razón por la que se percibe a la CDMX y sus alcaldías como “inseguras”, cuando los índices que lleva el gobierno dicen otra cosa.

Pero no hay que dejar de lado el propósito fundamental que tienen los medios de comunicación, el informar, y dar a conocer a la ciudadanía lo que realmente está ocurriendo en todos los ámbitos, incluyendo la inseguridad. Quizás el gobierno de Brugada debería de trabajar en su estrategía de seguridad y no estar pidiendo a los medios que dejen de compartir la nota roja…

Adán Augusto deja la Coordinación de Morena en el Senado con solo 6 iniciativas presentadas

Trascendió que tras la salida de Adán Augusto López como coordinador de la fuerza parlamentaria de Morena en el Senado, este solo ha presentado un total de 6 iniciativas en los meses que tuvo el puesto, entre ellas algunas para convocar períodos extraordinarios…

Y es que en 15 meses, un total de 6 iniciativas dejan mucho que desear, sobre todo cuando se trata de iniciativas tan simples como el llamado a la sesión extraordinaria; además de esta el morenista propuso inscribir en el Muro de Honor del Senado una leyenda relacionada con la diplomacia mexicana e iniciativas reglamentarias para el funcionamiento interno del senado.

También impulsó reformas a diversos artículos de la Constitución, en materia del Poder Judicial y del funcionamiento del Congreso…

De pinta de bardas a promoción de cachuchas de Rafa Loera

A través de redes sociales, llamó la atención que el Secretario de Desarrollo Humano y Bien Común, Rafael Loera, pasó de pintas de bardas, a uniformar a su personal promocionando su imagen.

De acuerdo a la imagen que circula, las cachuchas son con la misma tipografía de las bardas que circulan ya en distintos puntos de la Capital.

La lucha por la Capital desde que la gobernadora, Maru Campos, dio luz verde, ha permitido que todos los que nombró comiencen con sus actividades de promoción personal.

Consejeros del INE… ¿a las filas del PAN?

Se dice que con la cercana salida de tres consejeros del INE, algunos actores de Morena aseguran que los consejeros son afines a la derecha y estos podrían aparecer en los próximos meses dentro de las filas del partido Acción Nacional, e inclusive, podrían aspirar a la diputación federal por el partido.

Bien lo dijo el vicepresidente de la Cámara de Diputados, Sergio Gutiérrez, quien aseguró que siempre han estado en contra de Morena y en su momento, encaró a los consejeros preguntándoles si se irían al PAN.

Será el 4 de abril que los consejeros, Dania Ravel, Claudia Zavala y Jaime Rivera, dejen su cargo tras 9 años, habrá que ver si tras su salida se unen a la derecha o toman otro puesto...

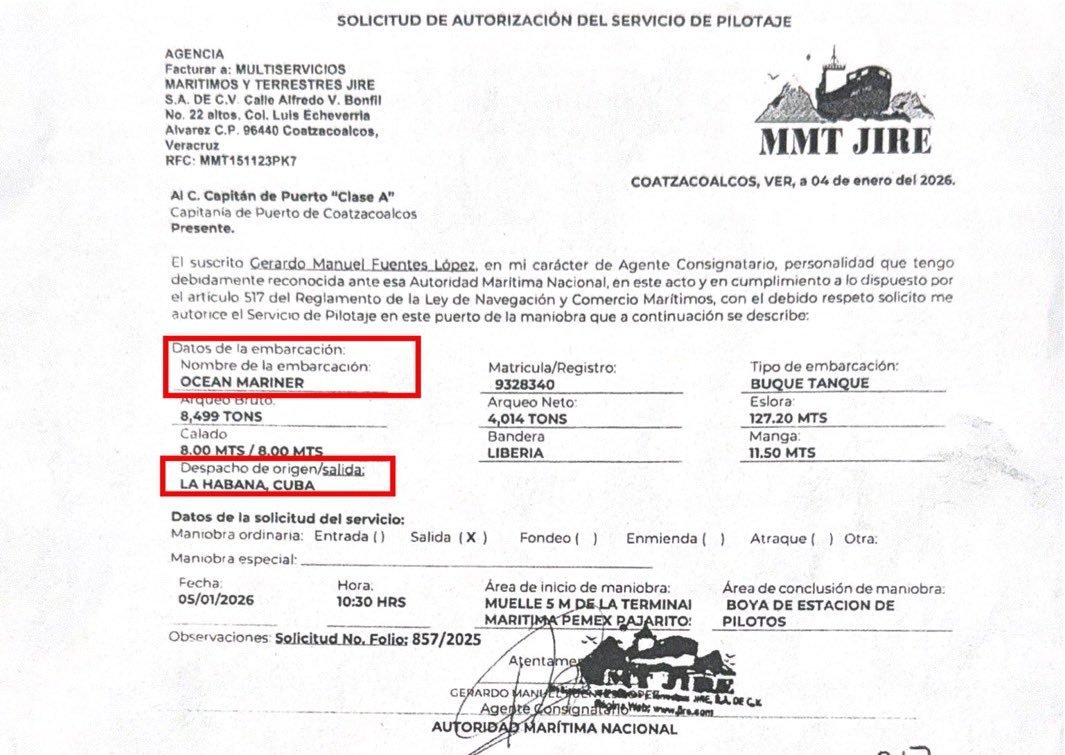

La 4T declara asunto de seguridad nacional la entrega de gasolina al régimen cubano, para no rendir cuentas

Mientras la economía de las familias mexicanas se ve presionada por los altos costos de los combustibles y PEMEX atraviesa una de las crisis financieras más agudas de su historia, el envío sistemático de crudo a Cuba se ha convertido en un "agujero negro" que la 4T ha clasificado como asunto de “seguridad nacional” para ocultar la información.

Se calcula que, tan solo durante el 2025, México habrá enviado aproximadamente 17 millones de barriles de petróleo al régimen cubano del que la 4T se niega a dar respuesta.

Se desconoce cuánto dinero representa esta operación, no hay claridad sobre si se vende a precio de mercado o bajo tarifas preferenciales, no existe un registro abierto del flujo constante de crudo.

Los impuestos de los mexicanos se están utilizando para subsidiar directamente a un régimen autoritario.

PEMEX continúa sumida en deudas multimillonarias y los mexicanos enfrentan precios de gasolina en niveles históricos y el incumplimiento de los 10 pesos al litro de gasolina

Recuerdan en redes que Petro aseguró que Sheinbaum militó en la guerrilla M-19

En medio de la polémica que se ha desatado tras la captura de Nicolás Maduro, y las amenazas que ha hecho Donald Trump contra otros países, incluyendo Colombia y México, se recuerda que en 2024 Gustavo Petro aseguró que Claudia Sheinbaum militó en la guerrilla M-19 en México.

Señalan que fue el mismo Gustavo Petro quien señaló que Claudia Sheinbaum fue integrante del M-19, una guerrilla colombiana, de la que él también fue militante, "Claudia fue miembro del M-19, es decir, que, para quienes no quieren dos tazas, ahora el M-19 ha dado dos Presidentes en América Latina”.

Trump anunció, con un tono desafiante, que pronto aplicará en Colombia su receta militarista, como lo hizo en Venezuela, que terminó con la captura de Nicolás Maduro y su esposa, Cilia Flores. “Puede haber una misión de EU en Colombia”, advirtió. El presidente estadounidense asegura que la suerte de Petro depende de él.